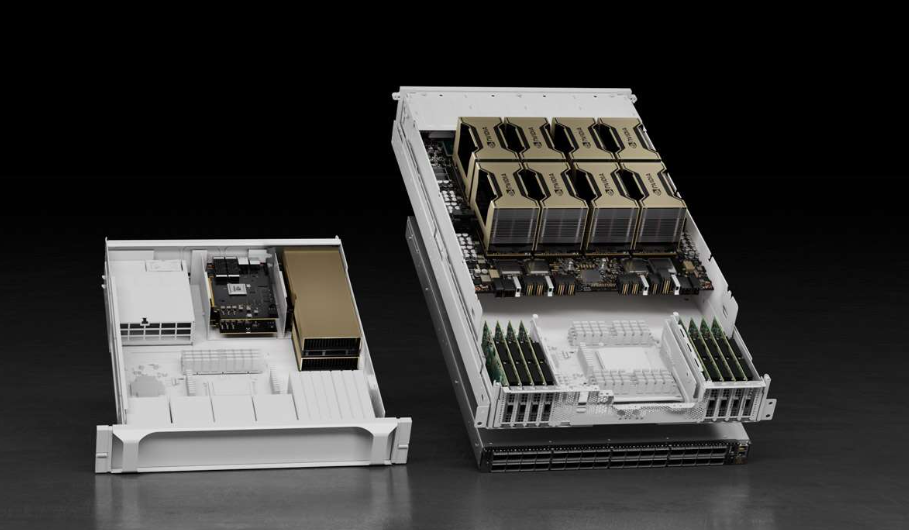

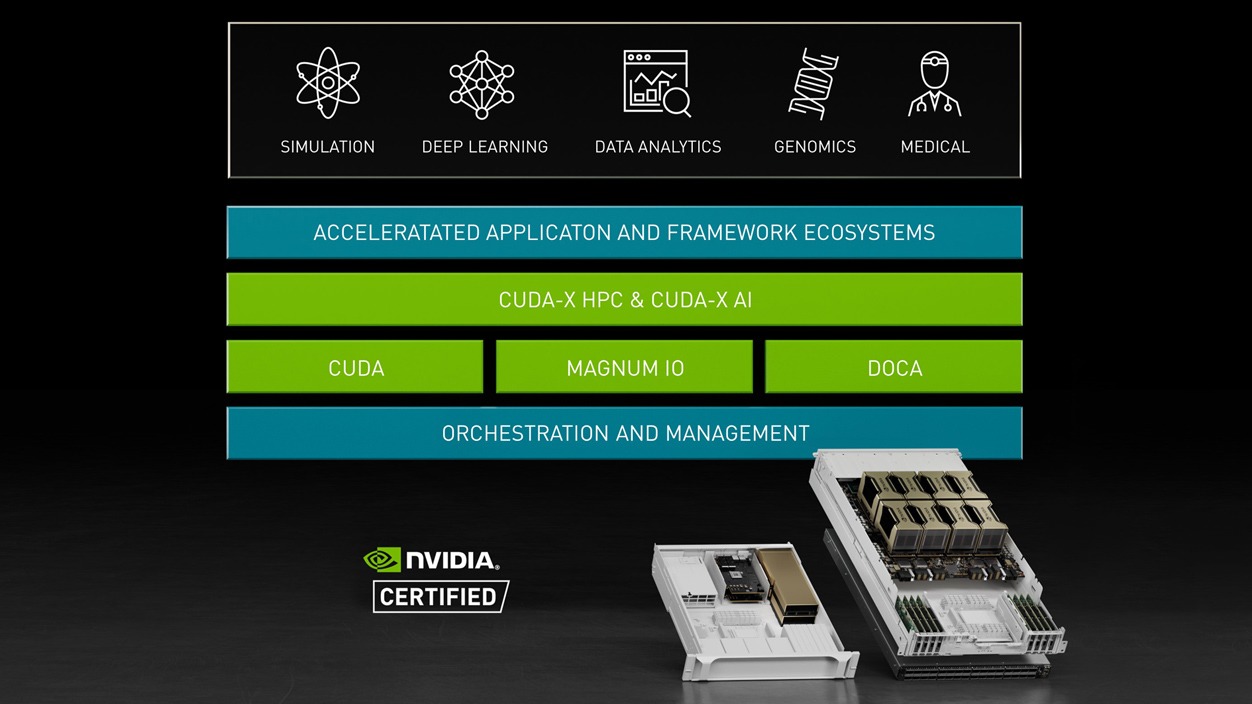

NVIDIA HGX 将 NVIDIA A100 Tensor Core GPU 与高速互连技术相结合,打造功能强大的服务器。HGX 拥有 16 个 A100 GPU,具有高达 1.3 TB 的 GPU 显存和超过 2 TB/秒的显存带宽,可实现非凡加速。

与前几代产品相比,HGX 借助 Tensor Float 32 (TF32) 开箱即可为 AI 提供高达 20 倍的加速,同时借助 FP64 实现 2.5 倍的 HPC 加速。NVIDIA HGX 提供了令人惊叹的 10 petaFLOPS,为 AI 和 HPC 领域打造出全球性能强劲的加速扩展服务器平台。

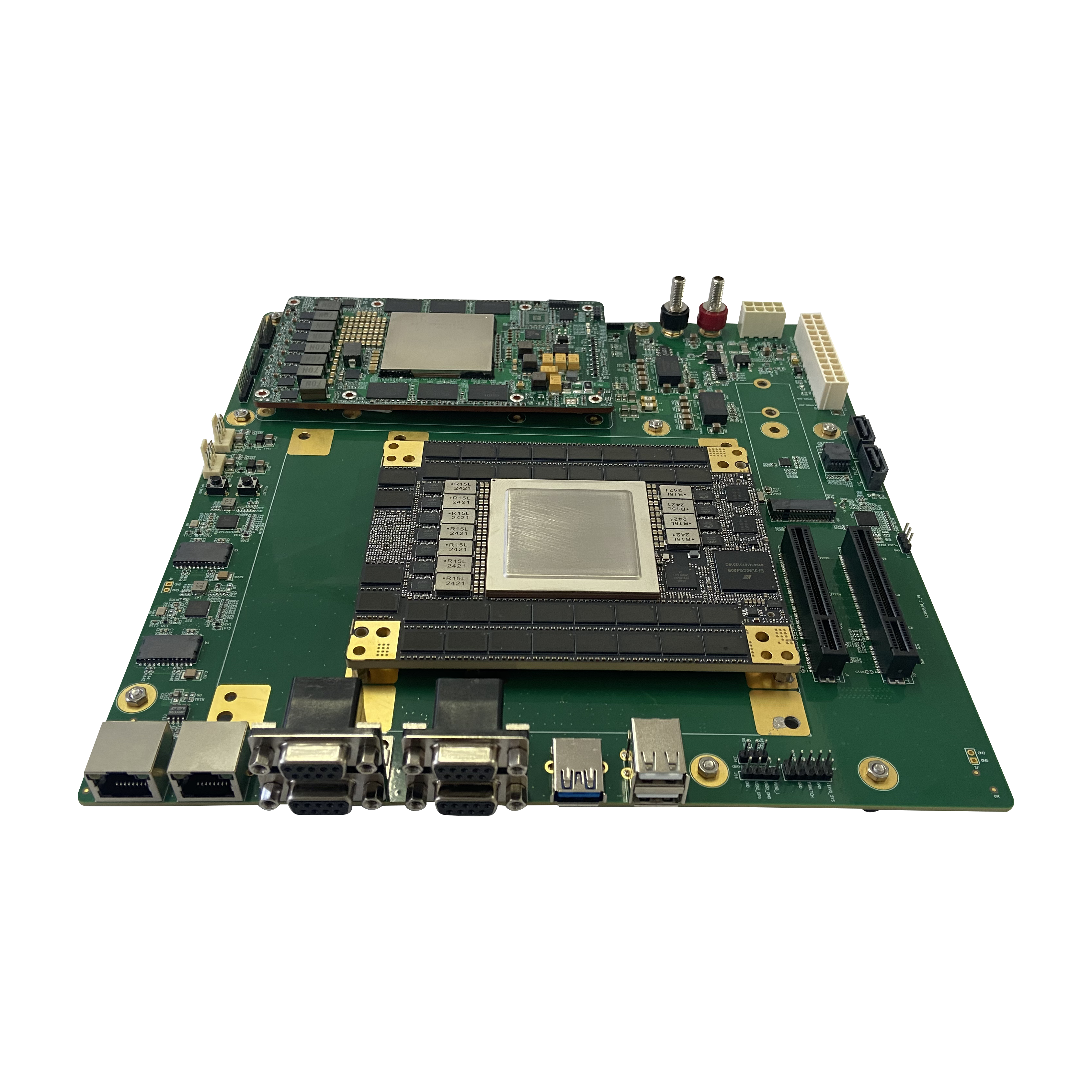

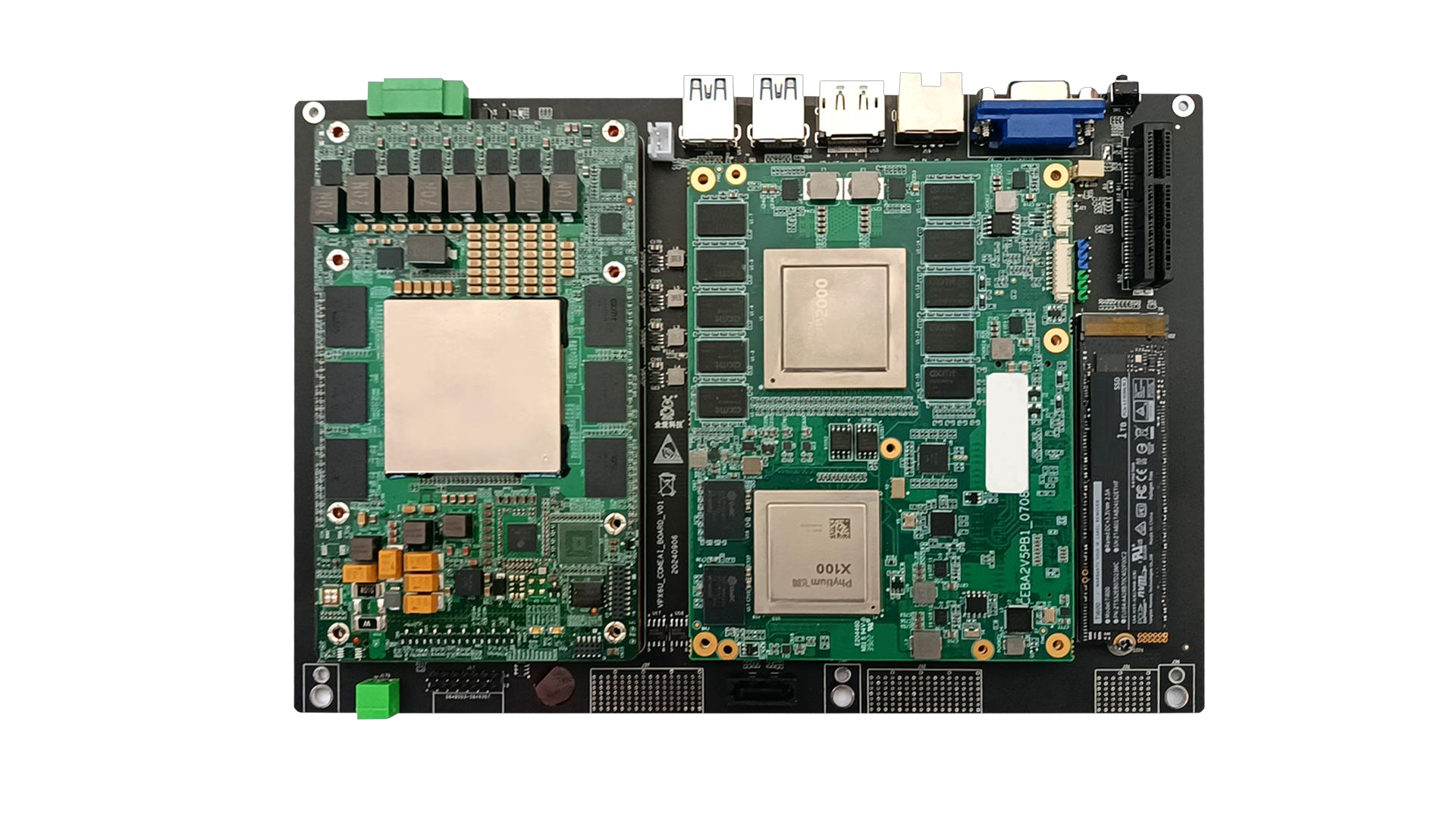

HGX 经过全面测试且易于部署,可集成至合作伙伴服务器中,以提供有保证的性能。HGX 平台提供 4-GPU 和 8-GPU HGX 主板并采用 SXM GPU,也可采用 PCIe GPU 的形式以提供模块化部署选项,为主流服务器带来卓越计算性能。