最新发布的NVIDIA Jetson AGX Orin提升边缘AI标杆,使我们在最新一轮行业推理基准测试中的领先优势更加明显。

April 6, 2022 by 英伟达中国

在首次参加行业MLPerf基准测试时,基于NVIDIA Ampere架构的低功耗系统级芯片NVIDIA Orin就创造了新的AI推理性能纪录,并在边缘提升每个加速器的性能。

在此次第五轮生产级AI行业基准测试中,NVIDIA及其合作伙伴继续在所有机器学习的工作负载和场景中展现出了高性能和广泛的生态系统。

在边缘AI领域,NVIDIA Orin预生产版本在六项性能测试中的五项处于领先地位,其运行速度比上一代Jetson AGX Xavier快了5倍,能效平均提高了2倍。

NVIDIA Orin现已加入到用于机器人和自动化系统的NVIDIA Jetson AGX Orin开发者套件。包括亚马逊网络服务、约翰迪尔、小松、美敦力和微软Azure在内的6000多家客户使用NVIDIA Jetson平台进行AI推理或其他任务。

这款系统级芯片也是NVIDIA Hyperion自动驾驶汽车平台的关键组成部分。中国最大的电动汽车制造商比亚迪近期宣布,他们将在其新一代自动驾驶电动汽车中使用内置Orin的DRIVE Hyperion架构。

Orin同样也是NVIDIA Clara Holoscan医疗设备平台的关键组成部分,且该平台可供系统制造商和研究人员用来开发新一代AI仪器。

小模块合体成为大堆栈

包括Jetson AGX Orin在内的NVIDIA GPU是唯一能够运行所有六项MLPerf基准测试的边缘加速器。

凭借JetPack SDK,Orin可以运行整个NVIDIA AI平台,这个软件堆栈已经在数据中心和云端得到了验证,并且获得了NVIDIA Jetson平台100万名开发者的支持。

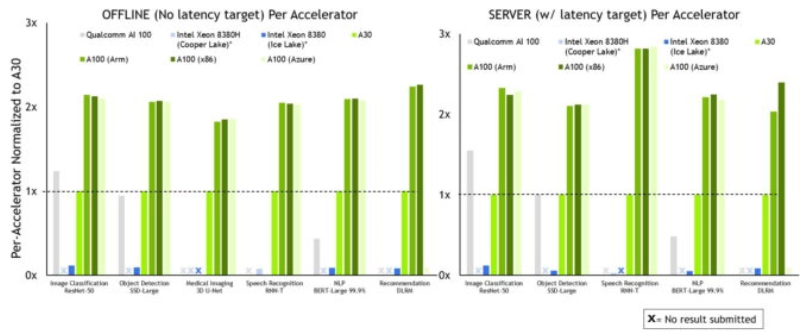

在最新一轮MLPerf推理测试中,NVIDIA及合作伙伴继续在所有测试和场景中展现出领先的性能。

MLPerf基准得到了亚马逊、ARM、百度、戴尔科技、Facebook、谷歌、哈佛大学、英特尔、联想、微软、斯坦福大学和多伦多大学等机构的广泛支持。

更多的合作伙伴与结果提交数量

NVIDIA AI 平台再次吸引了来自最广泛合作伙伴生态系统的最多 MLPerf 提交。

Azure在12月份的MLPerf训练测试中表现出色,在本轮AI推理测试中也取得了优异的成绩,这两场测试都使用了NVIDIA A100 Tensor Core GPU。Azure的ND96amsr_A100_v4实例在几乎所有推理测试中都与我们提交的性能最高的8个GPU相媲美,展现了公共云随时可以提供的能力。

系统制造商华硕和新华三在本轮测试中首次使用NVIDIA AI平台提交MLPerf结果。他们加入了戴尔科技、富士通、技嘉、浪潮、联想、宁畅和美超微等已经提交了二十多个NVIDIA认证系统结果的系统制造商的行列。

MLPerf的重要性

我们的合作伙伴深知MLPerf是一个客户用来评估AI平台和供应商的宝贵工具,因此纷纷参与这项测试。

MLPerf的各项测试涵盖了当下最流行的AI工作负载和场景,用户可以依据该基准了解AI平台在各类工作中的预期性能。

凭借软件大放异彩

我们在测试中使用的所有软件都可以从MLPerf软件库中获得。

我们的推理结果来自两个关键组件——用于优化AI模型的NVIDIA TensorRT和用于高效部署模型的NVIDIA Triton推理服务器。您可以在我们的GPU优化软件目录NGC上免费获得它们。

全球各地的企业机构正在采用Triton,包括Amazon和微软等云服务提供商。

我们不断将优化成果加入到NGC上的容器中,让每一位用户都能使用具有领先性能的AI进行生产。